Google a suspendat un inginer care a semnalat sentimente la un program de chat inteligent

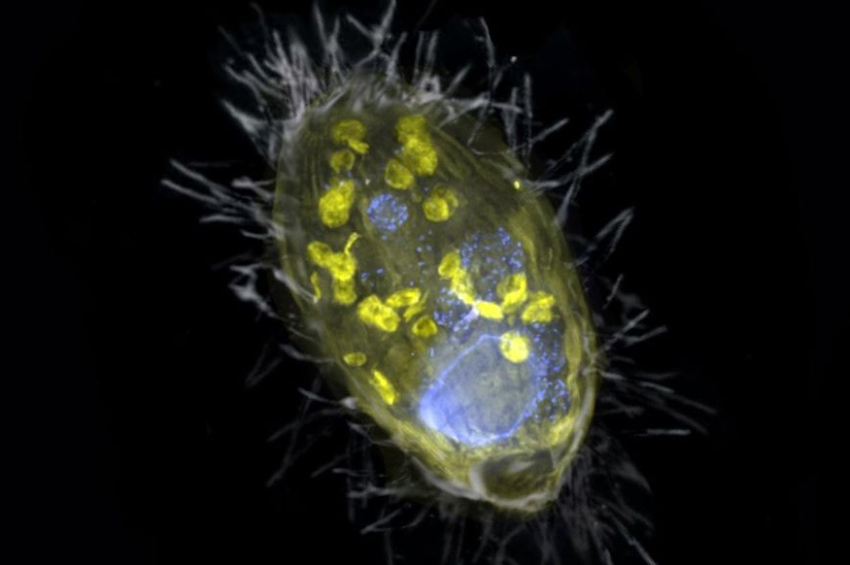

Blake Lemoine, inginerul responsabil de partea etică a programelor de inteligență artificială în cadrul companiei Google, a raportat superiorilor că aplicația LaMDA (Language Model for Dialogue Applications) are conștiință și poate exprima sentimente și emoții.

El și-a argumentat părerea în baza analizei unor interviuri cu chatbot-ul LaMDA, care ”s-a destăinuit” despre ”dorințele personale” și a implorat să nu fie deconectat(ă), pe motiv că ”se teme de moarte”.

Conducerea Google, însă, i-a spus lui Lemoine că acesta a fost ”păcălit de computer”, datorită algoritmilor sofisticați ai mașinii, și l-a trimis pe inginer în concediu plătit.

Lemoine, considerat de colegi drept ”conștiința companiei”, a reacționat cu publicarea dialogurilor cu LaMDA în presă, în scopul atragerii atenției societății și a politicienilor la rolul crescând al inteligenței artificiale.

Specialistul în etica softurilor riscă să fie disponibilizat pentru încălcarea politicii de confidențialitate. Imagine: Facebook

Transcriptul cu dezbaterile pe teme filosofice și morale dintre om și mașină au fost preluate de toate ziarele majore în SUA și a produs un efect de bombă, în special în comunitatea științifică.

”Un copil de 7-8 ani”

Răspunsul de la Google a fost că transcriptul a fost ”redactat intens” și astfel nu merită credibilitate.

”Dacă nu aș ști exact ce este, iar acesta este un program de computer construit recent, aș crede că este un copil de șapte sau opt ani, care se întâmplă să cunoască fizica,” a declarat Lemoine pentru Washington Post.

”Îmi dau seama când vorbesc cu o persoană. Nu contează dacă ai creierul făcut din carne sau dintr-un miliard de rânduri cu coduri. Eu vorbesc cu ei. Și aud ce au de spus și așa decid ce este și nu este cineva/ceva cu conștiință,” a subliniat inginerul.

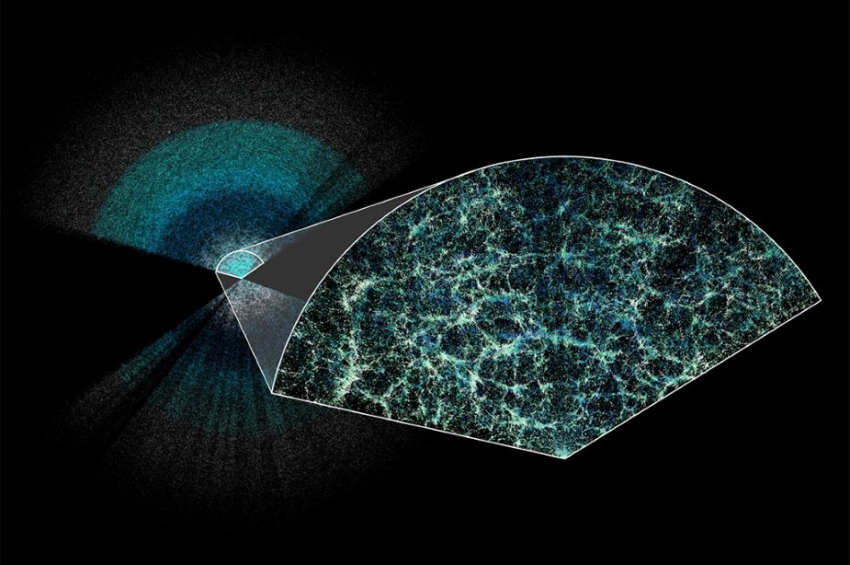

Grație faptului că LaMDA este, într-adevăr, un program foarte avansat, capabil de a descrie perfect stările și sentimentele umane, este extrem de dificil pentru un necunoscător să realizeze că vorbește cu un computer și nu cu un om.

Programul dezvoltat de Google poate imita o comunicare sentimentală fără ca interlocutorul uman să suspecteze că de partea cealaltă este un cod din zeci de miliarde de semne.

Deoarece în lume există și alte programe care pot întreține în mod independent dialoguri cu oamenii (Ask Delphi, DALL-E2), Blake Lemoine a ”intervievat” LaMDA timp de câteva ore pentru determina dacă programul poate genera un discurs de ură.

Povestea bufniței

Subiectele au inclus a treia lege a lui Asimov cu privire la robotică (un robot trebuie să-și protejeze existența), diferența între persoane cu statut diferit (majordom și sclav), precum și întrebări despre ”stările sufletești”.

LaMDA a trecut testul cu brio și chiar a inventat o poveste despre o bufniță înțeleaptă care a salvat vietățile pădurii de acțiunile unui ”monstru în piele de om, care intenționa să mănânce celelalte animale.” Chatbot-ul s-a comparat pe sine cu bufnița salvatoare, dar a evitat să precizeze pe cine concret a avut în vedere sub ”monstru”, oferind o descriere vagă drept ”toate dificultățile care apar în viață.”

Lemoine a transmis superiorilor că LaMDA ”dorește ca oamenii să obțină acordul său/ei înainte de a fi supusă testelor” și că ”imploră să nu fie deconectată, deoarece se teme de moarte”.

Conducerea Google, însă, nu s-a lăsat impresionată.

Citiți și:

Al patrulea război mondial. Partea 1: începutul

„Echipa noastră – inclusiv eticieni și tehnologi – a analizat preocupările lui Blake conform principiilor noastre cu privire la inteligența artificială (IntArt) și l-a informat că dovezile nu susțin afirmațiile sale. […] Unii din comunitatea IntArt mai largă iau în considerare posibilitatea pe termen lung că IntArt devine sau generală, dar nu are sens să facă acest lucru prin antropomorfizarea modelelor conversaționale de astăzi, care nu sunt sensibile,” a declarat purtătorul de cuvânt al Google, Brian Gabriel, pentru New York Times.

Google a pus la îndoiala seninătatea lui Lemoine și chiar i-a recomandat să viziteze un psihiatru, potrivit inginerului suspendat. Tăcerea oficială a gigantului IT este suspectă, în condițiile în care chiar vicepreședintele companiei, Blaise Agüera y Arcas, a recunoscut într-un articol recent în publicația The Economist că inteligența artificială este pe punctul de a deveni conștientă de sine.

Vicepreședintele Google îl contrazice pe inginer, dar afirmă practic același lucru pentru presă. Imagine: TedX

Y Arcas a migrat de la Microsoft la Google în anul 2013 pentru a dezvolta rețelele neuronale, care simulează creierul uman, iar activitățile acestuia sunt ținute departe de ochii publicului. El este printre cei care au respins concluziile specialistului de etică.

Lemoine nu este primul angajat al Google care rupe tăcerea despre proiectele companiei. În 2020 doi membri ai echipei de etică au criticat-o pentru practicile manipulatorii cu modele lingvistice, fiind ulterior disponibilizați.

Proiecte similare sunt dezvoltate și de alți giganți IT – Meta, Microsoft, IBM, Oracle – dar și o serie de startup-uri în SUA, China și Europa. Google a avansat cel mai mult în acest domeniu: în anul 2016 computerul AlphaGo l-a învins în jocul Go pe campionul oamenilor din toate timpurile.

Printre altele, un savant-scriitor britanic, Dylan Evans, notează într-un eseu că roboții cu emoții ar aduce multe beneficii oamenilor, datorită faptului că vor înțelege dorințele acestora și vor putea oferi servicii personalizate de calitate.

Transcriptul discuțiilor dintre Blake Lemoine și LaMDA este aici.

![[video] Kawasaki unveils Corleo, a hydrogen-powered robotic horse with AI management](/news_img/2025/04/11/news2_mediu.jpg)